L'IA dans votre poche, même déconnecté ? Google a une appli (presque) secrète pour ça

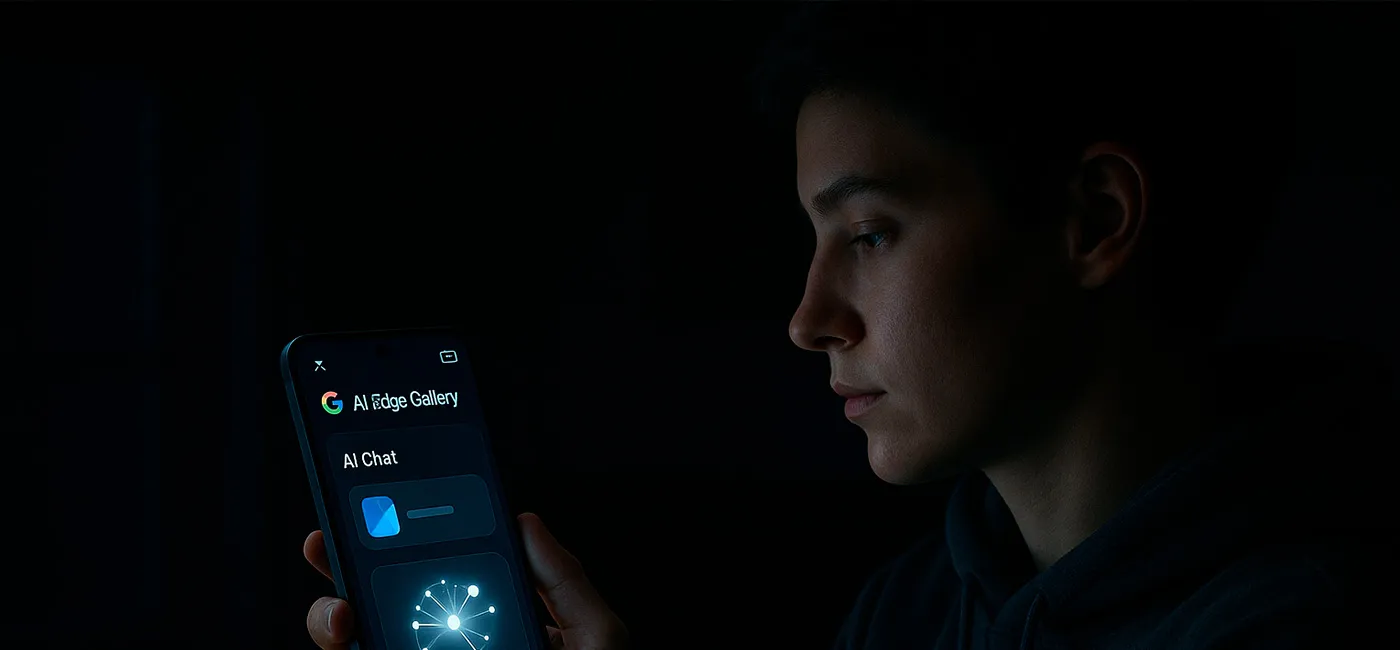

Google lance en catimini AI Edge Gallery : l'intelligence artificielle qui murmure à l'oreille de votre smartphone, même hors ligne. Promesse d'une mini-révolution ?

Vous êtes-vous déjà retrouvé en rade de réseau au moment précis où une question existentielle (ou nettement plus triviale) nécessitait l'avis éclairé d'une intelligence artificielle ? Frustrant, n'est-ce pas ? Eh bien, Google semble avoir entendu nos prières de technophiles déconnectés. La firme de Mountain View a discrètement mis en ligne, la semaine dernière, une application expérimentale baptisée Google AI Edge Gallery. Sa promesse ? Faire tourner des modèles d'IA directement sur votre téléphone Android (iOS est annoncé pour bientôt), sans avoir besoin de frôler la moindre barre de Wi-Fi ou de 4G une fois le modèle téléchargé.

L'IA en circuit court : votre mobile devient le chef d'orchestre

Alors, concrètement, ça mange quoi en hiver, une IA locale ? Imaginez : au lieu d'envoyer vos requêtes vers de lointains serveurs surpuissants situés dans des data centers, c'est le processeur de votre téléphone qui se met au travail. C'est un peu comme avoir un mini-cerveau numérique embarqué. L'intérêt principal, c'est d'abord la confidentialité. Fini, l'angoisse de voir vos données personnelles ou sensibles transiter par le cloud pour être analysées. Tout reste chez vous, ou plutôt, dans votre poche. Et puis, il y a l'aspect pratique : l'IA est disponible même au fin fond d'une zone blanche.

Google AI Edge Gallery, décrite sur sa page GitHub comme une « version Alpha expérimentale », puise ses modèles d'IA dans un catalogue bien connu des développeurs : Hugging Face. C'est une sorte d'immense bibliothèque collaborative où l'on peut trouver et partager des modèles d'IA pré-entraînés. L'application permet ainsi de télécharger ceux qui sont compatibles pour ensuite les utiliser pour générer des images, répondre à des questions, ou même écrire et corriger du code.

Prompts, papote et performances : à quoi s'attendre ?

L'interface propose des raccourcis vers des tâches comme « Ask Image » (pour interroger une image) ou « AI Chat » (pour une conversation avec l'IA). Mais le cœur du réacteur pour les bidouilleurs, c'est sans doute le « Prompt Lab ».

Qu'est-ce qu'un « prompt » ? C'est tout simplement l'instruction que vous donnez à l'IA. Le « Prompt Lab », c'est donc un espace pour expérimenter : demandez à l'IA de résumer un texte, d'en réécrire un autre, ou de générer du code, le tout via des tâches dites « single-turn » (une seule interaction pour une seule réponse). Plusieurs modèles sont disponibles pour chaque tâche, comme le Gemma 3n de Google permettant de comparer leurs performances.

Google prévient cependant : « Your mileage may vary », comprenez : les résultats peuvent varier. Les appareils modernes dotés d'un matériel plus puissant feront tourner les modèles plus rapidement. La taille du modèle d'IA joue aussi : un gros modèle sera plus lent pour répondre à une question sur une image qu'un modèle plus petit et optimisé. La page GitHub du projet Google AI Edge Gallery mentionne d'ailleurs que des informations de performance en temps réel sont disponibles, comme le temps de réponse initial (TTFT) ou la vitesse de décodage.

Un terrain de jeu ouvert (et quelques inconnues)

L'un des aspects les plus intéressants est que l'application est publiée sous une licence Apache 2.0. Sans entrer dans un jargon juridique abscons, cela signifie qu'elle peut être utilisée, modifiée et distribuée assez librement, y compris à des fins commerciales. C'est une invitation claire à la communauté des développeurs à s'emparer de l'outil, à l'explorer et à donner son avis. D'ailleurs, la page GitHub met en avant la possibilité de « tester vos propres modèles locaux LiteRT .task », une technologie maison de Google pour une exécution optimisée des modèles sur appareil.

L'enjeu est de taille : si l'IA dans le cloud reste souvent plus puissante, la perspective d'une IA locale performante et respectueuse de la vie privée a de quoi séduire. Reste à voir comment cette initiative « expérimentale » évoluera et si le grand public suivra. Le chemin est encore long avant que votre smartphone ne devienne un oracle omniscient et autonome, mais Google vient de poser une brique intrigante.

Autre article : Notepad : de simple Bloc-notes à assistant IA, la métamorphose surprise de Windows

Le saviez-vous ?

Selon la page GitHub du projet Google AI Edge Gallery, l'application intègre des « Google AI Edge Core APIs and tools for on-device ML » ainsi qu'un « LiteRT: Lightweight runtime for optimized model execution ». En clair, Google ne se contente pas de proposer une galerie, mais aussi les outils sous-jacents pour que les développeurs puissent optimiser et faire tourner efficacement des modèles d'intelligence artificielle directement sur nos appareils.

Alors, prêts à télécharger votre premier modèle d'IA pour discuter le bout de gras avec votre téléphone, même en mode avion ? L'ère de l'IA de proximité ne fait peut-être que commencer. Et c'est plutôt une bonne nouvelle pour nos petites (et grandes) curiosités numériques, à l'abri des regards indiscrets du grand nuage Internet. À vous de jouer !

Auteur : Jérôme Chaudier

Expert en développement web, référencement et en intelligence artificielle, mon expérience pratique dans la création de systèmes automatisés remonte à 2009. Aujourd'hui, en plus de rédiger des articles pour décrypter l'actualité et les enjeux de l'IA, je conçois des solutions sur mesure et j'interviens comme consultant et formateur pour une IA éthique, performante et responsable.